人工智慧變身法律小幫手

十幾年前,電腦會揀土豆已經夠驚奇,現在的 AI 更是大進擊,能辨識人臉、駕駛汽車,根據 2019 年眾多媒體報導,歐洲愛沙尼亞甚至即將推行「AI 法官」!法律事務涉及事實認定、法條解釋與價值規範等多重問題,人工智慧果真已如此高「智慧」,有能力涉入複雜的法律領域?

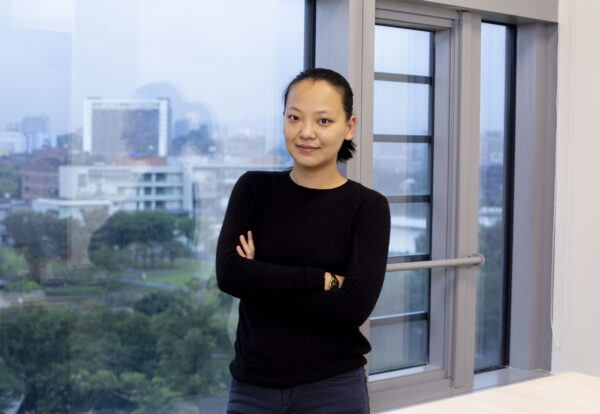

圖│研之有物(資料來源│〈人工智慧在台灣〉演講,陳昇瑋)

中研院李建良特聘研究員說:「將 AI 應用到法律訴訟其實並非未來式,而是行之有年的現在式。」

在美國,近年法院已廣泛運用「COMPAS」系統,這是一套由商業公司開發的 AI ,幫助法官評估被告的再犯風險,作為量刑的準據。COMPAS 會進行大量問答調查,依據被告回答、年齡、過往犯罪紀錄與類型等各項資料,推估被告的再犯率,給出 1-10 的危險指數,最後由法官決定被告服刑的長短。

有研究指出,AI 判定為高風險者,63% 在交保期間犯罪,其中 5% 犯下性侵或謀殺。做為法官小幫手,AI 似乎確實能發揮一定程度的「鷹眼」,預測危險性。

圖│取自量刑趨勢建議系統網頁

法官不是人?!別急,再等等

從現況來看,人工智慧確實已進入國家司法系統,但目前仍作為「專家團隊」扮演輔助角色,由法官做裁決。那麼下一步, AI 有可能獨當一面坐上審判席嗎?

愛沙尼亞的 AI 法官計畫,似乎就朝著這個方向前進。

根據報導,AI 法官將處理小額民事訴訟案件(少於 7000 歐元,台幣約 24 萬),由原告方輸入訴訟對象、金額、提告理由等。AI 系統能從過往大量判例學習,解析法條做出判決。換句話說,隔壁鄰居摔壞你的 iPhone,你一狀告到法院,會由 AI 判定誰勝訴,鄰居該賠你一台手機或折價金額。對結果不服?可以上訴,將有人類法官審理。這項超級計畫如果成真,「法官不是人」恐怕就要從罵人話變為描述句了!

不過,李建良特別澄清:「媒體報導後,我們研究團隊成員曾請教愛沙尼亞法界人士,目前所知這是數位政府計畫的一部分,但應該還只停在『計畫』階段。」

他強調,若要把國家審判權完全交給 AI ,必定需要法源基礎,明確建立一套法規方案。由於目前愛沙尼亞並沒有出現相關法規,這個突破仍是「只聞樓梯響」。

AI 法官的技術邊界:它能做出好判決嗎?

儘管 AI 尚未披上法官袍,但愛沙尼亞的構想彷彿是驚天一雷,預示出可能的未來圖像。許多人或許同樣好奇:AI 當法官究竟行不行?

李建良分成不同層次來討論:

行不行有兩層涵義:能力上行不行,規範上可不可以。

第一層次是「可能性」問題:AI 法官足以擔任人類法官的角色嗎?更直白地問:AI 真有那麼厲害,能夠做出好判決?

要確認 AI 的能力,首先我們得問:什麼是好判決?

「這牽涉社會對法院判決的評斷標準。」李建良分析,一種標準是檢視「判決結果」;另一種則是審視「判決理由」,法官在判決書詳述的心證,如調查結果、採信哪些證據、證據效力、法條依據等。

若觀察近年台灣社會的現象,大眾似乎較關注判決結果。好比引發社會矚目的「台鐵殺警案」,這樁尚未確定的爭議案件,引發了司法當局對司法鑑定制度的重視與檢討,而輿論譁然多半是殺人無罪的結論,批評法官「不接地氣」,關於心證過程的討論相對較少些。

換言之,假如重視結果,那不難想像 AI 法官有能力透過歸納、類比分析對案件做出判決。但若我們在乎法官為什麼、如何做出裁決,依照目前技術和愛沙尼亞計畫,AI 所產出的可能只有答案,但沒有理由(或較簡式的理由)。

這形成了第一重挑戰:

若 AI 法官無法清楚說明理由,我們如何檢視它的判決好不好?有沒有瑕疵?

有些人也質疑,AI 的精準、一致可能反倒是弱點。現行 AI 不具有真正理解他人的能力,無法實際參與答辯交鋒和開庭審理,而許多訊息來自臨場、個別案例的判讀,並非用數據化與資料化就足夠解釋,背後涉及文化、風俗、情境常識,相當複雜。

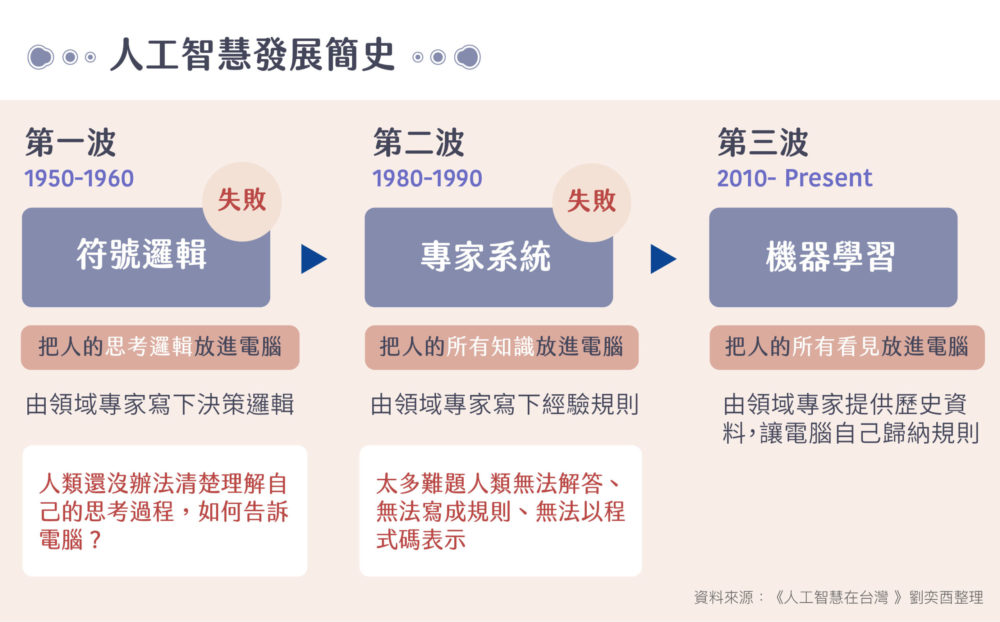

圖│ 研之有物

不過,AI 派並沒有全輸!

首先,技術可能超前突破,讓 AI 未來也有能力寫判決書、說明論證。另外若拿現行制度相比,美國陪審制同樣只宣告:「陪審團認為無罪」,不會附上理由。更何況所謂的情境判斷,經常也會造成主觀性偏誤,《美國國家科學院院刊》(PNAS)研究發現,接近午餐時間法官對假釋認定較嚴格,用餐休息後,假釋審查就變寬鬆了!

想要假釋,還得祈禱法官吃飽飽?恐怕多數人難以接受。

鐵面無私包青天? 小心 AI 的內建歧視

總地來說,理性、客觀幾乎是 AI 的最大光環,以準確一致的邏輯做判斷,不受法官個人情緒與好惡影響。

但真是這樣嗎?許多研究證實:AI 默默戴上了有色眼鏡! COMPAS 系統被抨擊帶有種族歧視,有色人種更容易被預測為高再犯率;亞馬遜招聘、蘋果信用卡信貸系統都曾被發現隱含性別差別待遇。

「這就如同人類一路走來看到的歷史不平等。」Amazon 資訊科學家說。

AI 系統在資料學習的過程,複製了人類長年累積的性別、種族、階級偏見。即便這些偏見已長久存在,但 AI 可能更強化不平等,因為人們會在毫無所覺下,信任科技工具的「客觀」訊息,對陌生人打分數。

然而,科技支持派沒有全盤放棄。AI 歧視是學來的,因應之策是在資料訓練時降低這些「標籤」,並且提供多樣性的資料。此外,比起人類刻意包裝、掩飾偏見,AI 反而有機會讓偏誤被「顯題化」,讓我們更加警覺,並進行修正。

綜合而論,若單從技術可能性評估,目前的 AI 也許不夠「聰明」,但是只要科技持續追求突破、進展,似乎沒有理由全盤否定 AI 法官可行性。畢竟,人類同樣也會犯錯、誤判、有偏見。

「從能力來看,AI 確實可以幫助人類、補位弱點,很值得期待未來發展。」李建良持平分析:「但國家是否應該開放制度,更重要的仍在第二層次的考量。」

AI 法官需要明確法源基礎

他點出更關鍵的第二層議題:從規範角度來看,讓 AI 當法官可不可以?

簡單來說,即使人工智慧有能力獨立分析、判決,我們應該把審判大權交給 AI 嗎 ?是否可能衍生倫理問題?

「第一個遇到的是:需不需要修憲?這是多數人忽略的框架。」專研憲法、行政法的李建良特別指出。法官的身分保障及審判獨立的要求直接寫在憲法上頭,但憲法規定的法官是否專指「人」呢?法學界很可能有不同論述。

如果憲法說的法官專指「人」,也就是法官審判權奠基在人的前提,勢必需要修憲。反之,就算憲法允許「非人」擔任法官,仍然需要修法 ── 如同剛拍板的《國民法官法》,國家必須建立一套法制來規範非人法官。例如,適用民事或刑事案件?能上訴嗎?上訴後交給另一位 AI 法官(AI 會有不同法官嗎?),或者由人類法官打掉重來?

價值選擇的難題:科技優勢 VS 法律原則

法源基礎僅是第一步,對整個社會而言,AI 法官挑戰的是價值選擇的難題。

2013 年,美國威斯康辛州法院參酌 COMPAS 風險指標,判處被告 Eric Loomis 6 年徒刑。Loomis 不服而上訴最高法院,認為法庭以 AI 系統裁決是一種「秘密審判」!要求說明 COMPAS 系統如何演算判斷出危險值。

這個案例顯然暴露了 AI 法官的價值衝突:演算法黑箱(black box)。

「在民主法治國家,法官不是個人,他代表的是國家。審判必須在公開透明的運作下,被監督、檢驗、究責。」李建良說:「法院公開審理、法官說明判決理由,都是來自這種被檢驗的要求。」

倘若披上法官袍的 AI ,無法開庭、詰問、說明判決理由,讓審判攤在陽光下,勢必挑戰現行的法院體制,也可能稀釋透明、公開、負責的司法價值。我們無從知道它為何會做出 A 判決,而不是 B 判決,不能確定它有沒有失誤,也難以確認責任歸屬。

Loomis 案也突顯出另一挑戰:代罪羔羊! AI 推測來自過往的資料,但「相似條件的其它人這麼做,不代表個別主體也會這麼做」。

這同時讓人擔憂 AI 的「因襲性」:社會信仰的美好價值是不斷翻轉、改變,有時正是因為劃時代的法院判決,才讓我們終於能破除傳統、確立新價值,例如美國法院推翻種族隔離平等制度,AI 法官會不會弱化、壓縮了法律肩負的深刻意義?

李建良直言,第一層次的「能力可行性」是人與 AI 的 比較參照,AI 能做到什麼,補足哪些人類弱點,帶來什麼優勢。

但最終,「倫理辯證」仍是無可迴避的關鍵核心,當新科技打破、牴觸基本價值,我們是否願意為了科技可能提供的「客觀公正」,放棄退讓這些原則?

圖│ iStock

人文關懷,也是艱困的價值論辯

「這不會是全面贊成/反對的選擇題,因為 AI 法官很難普遍性適用每一種案件。」李建良強調。

AI 在資料統整、數據分析上已大放異彩,導入科技新工具、人機合作,可以減輕法院負擔,也拉近一般人與訴訟裁決的距離。然而,法律範疇高度複雜,即便未來開放 AI 法官,也必定是在特定的條件、脈絡與案型。

他以行政法說明,「大埔農地要不要徵收?美麗灣渡假村能不能蓋?這類行政法案件極度複雜,牽涉環保、制度、法規多重衝突,還有價值選擇的命題,不太可能由 AI 獨立裁決。」

更重要的是,即使技術邊界有機會突破、修正,讓 AI 越來越聰明,我們也不應迴避第二層次的倫理辯證。這也正是人文學科最重要的價值關懷。

「我們很容易倒過來想,認為有這麼多好處,為什麼不開放、不使用?但人文學者關注的是價值倫理,一旦越過了某些界線,無論多少優勢,我們都必須謹慎、嚴肅地看待。」李建良提出艱難考驗做類比:

當你明確知道這人是兇手,卻沒有任何證據,這時我們要不要放棄無罪推定,不計手段堅持罪有應得?這就是價值選擇的論辯。很困難,但很重要!

圖│研之有物